先日、まぁまぁ労力をかけて作った機械学習モデルがいとも簡単に線形回帰モデルに負けたことを書きました。

あれから色々と考えなおし、更に良い特徴量が無いのか探し求めてました。

すると見逃していた特徴量があるではないですか。

早速、観察開始。

新たな特徴量

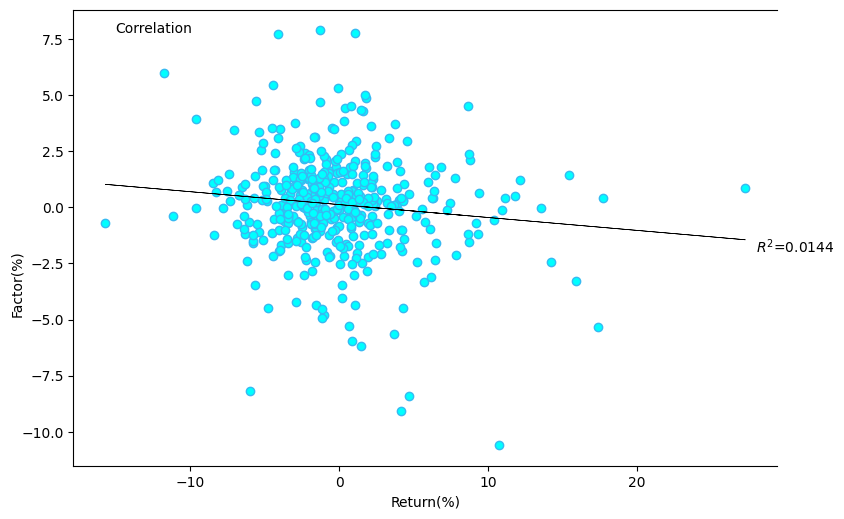

見逃していた特徴量はCORR^2=1.44で、他の強烈なものに対して、隠れた存在だったのです。

パッと見、悪くなさそうです。

第二・第四象限に良い感じにばらついているので、モデルに組み込みと精度が上がりそうな気がします。

俺の特徴量の入れ方

昔、ブログにも書きましたが自分はアンサンブルが好きです。

【メイン特徴量1+サブ特徴量1+サブ特徴量2+サブ特徴量3】

で作る一つのモデルよりも、同じ特徴量を使って、

【メイン特徴量1+サブ特徴量1】

【メイン特徴量1+サブ特徴量2】

【メイン特徴量1+サブ特徴量3】

の3つのモデルをアンサンブルする方が好きです。

この辺は好みなのでしょうけど。

また、株式などで使う市場平均PERみたいな過熱感を表す特徴量は全てのモデルにいれちゃったりします。

今回はサブが一つ見つかったので、もう一つモデルを作り、アンサンブルすることにしました。

結果は如何に

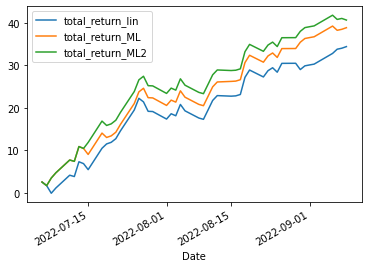

先日は非常に短い区間を比べたので、今回は少し区間を広げて7月からの成績で比べてみました。total_return_MLが従来モデル、total_return_ML2が今回のモデルです。そして、total_return_linは線形回帰モデル。

おー、やっぱり長期すると差がでるのですね。

線形回帰は直近は強いようですが。

とりあえずはアンサンブルしたものが良い結果を出すようでひとまずは安心してます。

自分のやっていることは間違っていなかった、はず。

今後はどうするのか

今回の改善したモデルを運用してゆき、調子が良ければロットを増やして行こうと思います。

また、1か月後良い傾向が続けば記事にしようと思います。

P.S.来週はアメリカ出張のため、ブログはお休みかもしれませんし、トレードネタ以外をアップするかもしれません。では。